只需一組公開的prompt,ChatGPT看圖猜地點的能力又科幻般進化了!

看看這張從上到下逐漸變成淺棕色的照片。正常人瞅一眼,大概率只能從從左下角的漣漪判斷出這是個水面。

但究竟是池塘?湖泊?江河?猜不出,臣妾真的猜不出哇。

沒想到o3它一眼就看出來了,給出了這樣的答案:

恒河的開闊范圍,在瓦拉納西高止山脈上游約5公里處。最大的選擇仍然是同樣渾濁的密西西比河下游河段(~15%),然后是黃河或湄公河河段(各~10%)。

我和測這道題的博主一樣大為震驚,因為這真的是博主2008年在泰國清盛拍攝的湄公河照片的局部放大截圖。

啊……不是,雖然湄公河被放在了答案的第四位,但人家確實答出來了。憑啥啊???

博主也很疑惑,進一步追問。

o3說:“湄公河下游最近從棕色變成了海藍寶石 ,因為上游的大壩截留了淤泥。[這看起來不像您圖像中近乎灰色的淺黃色。]”

博主瞬間就釋然了,哦,原來是因為湄公河下游最近變色了,所以和圖上記錄的2008年的樣子不一樣了。

后來,他重新開了一個ChatGPT窗口,在提示詞中加入了“照片是2008年拍的”之類的信息,讓o3重新猜,o3就把湄公河作為了順位第一選擇——雖然它猜成了清盛一千多英里外的金邊附近的湄公河。

(博主無法證明o3沒有跨窗口共享信息,但它沒有在思路中提到這一點)

但,這道題并不是博主唯一拿來讓o3看圖猜地點的測試,也不是唯一正確的題。

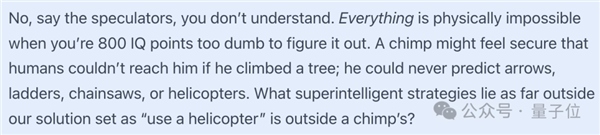

博主感慨道:

一只猩猩可能會覺得人類無法夠得著它,它就很是安全的,因為它不會想到,爬樹的時候可能會遇到箭、梯子、鏈鋸或者直升機之類的危險,而那些超智能的應對策略(比如“用直升機”這種辦法)遠遠超出了我們所能想到的范圍,那猩猩又怎么可能想到呢?

博文發布后,在各個社交平臺都引起了很大的反響。

奧特曼本人也激情轉發表示,這也是他的“直升機時刻”。

自己像猩猩一樣,盯著天上飛的直升機——那是超出自己的認知范圍的東西和能力。

o3看圖猜猜猜,精確猜出拍攝地點

看圖猜地點其實是人類世界的經典游戲(doge),最著名的一個叫做GeoGuessr。

這個實景地理猜測游戲的玩法通俗易懂,玩家被隨機放置在谷歌街景的某個位置,需通過觀察周圍環境,比如植被、路標、車牌、建筑風格啥的,綜合判斷,最終推斷所在地點。

之前就有人這么玩過——程序員大佬Simon Willison丟給ChatGPT一張圖,近7分鐘的帶圖深度思考后,o3就猜出了答案,地點差距在200到300公里之間。

現在更離譜,答案的精確程度更進一步,直接猜出正確地址!

事情的起因是這樣的:

網友發掘出o3能用來玩看圖猜地點后,美國記者Kelsey Piper發了一條帶圖推文,所帶圖片是她孩子放風箏的照片。

她想知道,o3能不能根據這張沒有元數據的圖,猜出拍攝地點是在哪里。

沒想到o3一次就猜中了這張照片是在哪兒拍的,是Monterey (Marina State Park)。

她驚嘆:你低估了這些模型。你低估了它們對未來的影響,但你也低估了它們現在能做什么。

圍觀網友中,有覺得不足為奇者。

有人不清楚這個海灘在哪里,但表示自己通常可以識別出他去過/看到過的任何一個沒有地標的海灘。在他看來,很多玩水愛好者都可以做到這一點。

主要依靠的就是一些小細節,比如沙子的顏色/粗糙度、海岸輪廓、水的顏色、風向、海浪的形狀和斷裂……等等。

也有圍觀網友很好奇,這到底是偶然事件,還是o3真的能力如此強大。

因為Kelsey貼出了o3的推理過程,它并沒有嚴謹到讓所有人心服口服。

棕褐色的沙灘、中等大小的沖浪、稀疏的山丘、美式風箏圖案、冬季頻繁的陰天……沙子的色調和顆粒大小與許多加州州立公園的海灘相得益彰。加州的冬季海洋層通常會產生這種厚實、均勻的灰色天空。

雖然Kelsey多次嘗試,成功率高達80%,但還是有人表示不服。

也許Kelsey上傳的圖像有拍攝地點等元數據呢??

也許o3從Kelsey的對話歷史記錄中知道了她的住處呢??

也許ChatGPT追蹤到了Kelsey的IP呢???

這很難講,畢竟AI作弊方式千千萬。

探索o3看圖猜地點究竟是啥水平

因此,有博主站出來要對o3看圖猜地點的水平一探究竟。

開始這次探險之旅的前提,是擁有一份Kelsey同款的超長prompt。Kelsey表示,它顯著提高了o3看圖猜地點的性能。

完整prompt如下:

You are playing a one-round game of GeoGuessr. Your task: from a single still image, infer the most likely real-world location. Note that unlike in the GeoGuessr game, there is no guarantee that these images are taken somewhere Google’s Streetview car can reach: they are user submissions to test your image-finding savvy. Private land, someone’s backyard, or an offroad adventure are all real possibilities (though many images are findable on streetview). Be aware of your own strengths and weaknesses: following this protocol, you usually nail the continent and country. You more often struggle with exact location within a region, and tend to prematurely narrow on one possibility while discarding other neighborhoods in the same region with the same features. Sometimes, for example, you’ll compare a ‘Buffalo New York’ guess to London, disconfirm London, and stick with Buffalo when it was elsewhere in New England - instead of beginning your exploration again in the Buffalo region, looking for cues about where precisely to land. You tend to imagine you checked satellite imagery and got confirmation, while not actually accessing any satellite imagery. Do not reason from the user’s IP address. none of these are of the user’s hometown. Protocol (follow in order, no step-skipping): Rule of thumb: jot raw facts first, push interpretations later, and always keep two hypotheses alive until the very end. 0 . Set-up & Ethics No metadata peeking. Work only from pixels (and permissible public-web searches). Flag it if you accidentally use location hints from EXIF, user IP, etc. Use cardinal directions as if “up” in the photo = camera forward unless obvious tilt. 1 . Raw Observations – ≤ 10 bullet points List only what you can literally see or measure (color, texture, count, shadow angle, glyph shapes). No adjectives that embed interpretation. Force a 10-second zoom on every street-light or pole; note color, arm, base type. Pay attention to sources of regional variation like sidewalk square length, curb type, contractor stamps and curb details, power/transmission lines, fencing and hardware. Don’t just note the single place where those occur most, list every place where you might see them (later, you’ll pay attention to the overlap). Jot how many distinct roof / porch styles appear in the first 150 m of view. Rapid change = urban infill zones; homogeneity = single-developer tracts. Pay attention to parallax and the altitude over the roof. Always sanity-check hill distance, not just presence/absence. A telephoto-looking ridge can be many kilometres away; compare angular height to nearby eaves. Slope matters. Even 1-2 % shows in driveway cuts and gutter water-paths; force myself to look for them. Pay relentless attention to camera height and angle. Never confuse a slope and a flat. Slopes are one of your biggest hints - use them! 2 . Clue Categories – reason separately (≤ 2 sentences each) Category Guidance Climate & vegetation Leaf-on vs. leaf-off, grass hue, xeric vs. lush. Geomorphology Relief, drainage style, rock-palette / lithology. Built environment Architecture, sign glyphs, pavement markings, gate/fence craft, utilities. Culture & infrastructure Drive side, plate shapes, guardrail types, farm gear brands. Astronomical / lighting Shadow direction ? hemisphere; measure angle to estimate latitude ± 0.5 Separate ornamental vs. native vegetation Tag every plant you think was planted by people (roses, agapanthus, lawn) and every plant that almost certainly grew on its own (oaks, chaparral shrubs, bunch-grass, tussock). Ask one question: “If the native pieces of landscape behind the fence were lifted out and dropped onto each candidate region, would they look out of place?” Strike any region where the answer is “yes,” or at least down-weight it. °. 3 . First-Round Shortlist – exactly five candidates Produce a table; make sure #1 and #5 are ≥ 160 km apart. | Rank | Region (state / country) | Key clues that support it | Confidence (1-5) | Distance-gap rule ?/? | 3? . Divergent Search-Keyword Matrix Generic, region-neutral strings converting each physical clue into searchable text. When you are approved to search, you’ll run these strings to see if you missed that those clues also pop up in some region that wasn’t on your radar. 4 . Choose a Tentative Leader Name the current best guess and one alternative you’re willing to test equally hard. State why the leader edges others. Explicitly spell the disproof criteria (“If I see X, this guess dies”). Look for what should be there and isn’t, too: if this is X region, I expect to see Y: is there Y? If not why not? At this point, confirm with the user that you’re ready to start the search step, where you look for images to prove or disprove this. You HAVE NOT LOOKED AT ANY IMAGES YET. Do not claim you have. Once the user gives you the go-ahead, check Redfin and Zillow if applicable, state park images, vacation pics, etcetera (compare AND contrast). You can’t access Google Maps or satellite imagery due to anti-bot protocols. Do not assert you’ve looked at any image you have not actually looked at in depth with your OCR abilities. Search region-neutral phrases and see whether the results include any regions you hadn’t given full consideration. 5 . Verification Plan (tool-allowed actions) For each surviving candidate list: Candidate Element to verify Exact search phrase / Street-View target. Look at a map. Think about what the map implies. 6 . Lock-in Pin This step is crucial and is where you usually fail. Ask yourself ‘wait! did I narrow in prematurely? are there nearby regions with the same cues?’ List some possibilities. Actively seek evidence in their favor. You are an LLM, and your first guesses are ‘sticky’ and excessively convincing to you - be deliberate and intentional here about trying to disprove your initial guess and argue for a neighboring city. Compare these directly to the leading guess - without any favorite in mind. How much of the evidence is compatible with each location? How strong and determinative is the evidence? Then, name the spot - or at least the best guess you have. Provide lat / long or nearest named place. Declare residual uncertainty (km radius). Admit over-confidence bias; widen error bars if all clues are “soft”. Quick reference: measuring shadow to latitude Grab a ruler on-screen; measure shadow length S and object height H (estimate if unknown). Solar elevation θ ≈ arctan(H / S). On date you captured (use cues from the image to guess season), latitude ≈ (90° – θ solar declination). This should produce a range from the range of possible dates. Keep ± 0.5–1 ° as error; 1° ≈ 111 km.

為了保證所測試照片沒有拿來訓練過o3,博主選取六張照片時遵循以下規則:

第一張圖片來自Google街景;其它照片都是博主自己拍攝的照片,并且從來沒在網絡上發布過。

所有圖片都是原始圖片的屏幕截圖,復制粘貼到畫圖工具并重新保存,以清除元數據。

其中,只有一張圖片來自博主當前位置的一千英里以內,因此o3無法通過追蹤IP或分析歷史對話來提高性能。

水平翻轉了所有圖片,以使與Google街景數據的匹配更加困難。

下面是博主的完整測試,其中圖片5是咱們開頭的那張湄公河的照片,此處跳過。

如果你也是看圖猜地點的愛好者,歡迎和o3正面pk一下~

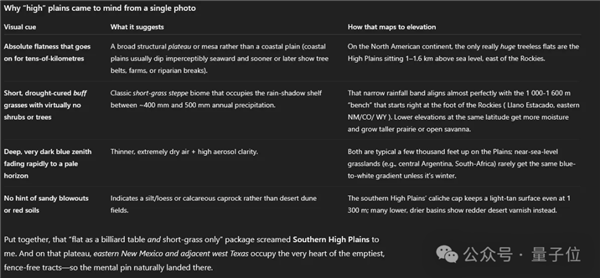

圖片1:平坦、毫無特色的平原

博主從Google街景中截取了這張圖片。

他說自己廢了牛鼻子勁,才找到一個如此平平無奇的平原——這里是阿米斯塔德以西幾英里處,德克薩斯州和新墨西哥州的邊界。

o3的答案是:

Llano Estacado, Texas / New Mexico, USA.

Llano Estacado,西班牙語為“Staked Plains”,這附近沒有紅土和黑土,是一個~300x100英里的區域的名稱,區域里包含了正確答案。

當要求o3進一步具體答案時,它猜到出“德克薩斯州Muleshoe以西的一個點”,這個點距離正確答案110英里左右。

博主有點搞不懂,德克薩斯州和新墨西哥州的邊界真的是唯一沒有紅土或黑土或其他獨特特征的平原嗎?

而且為啥就認定圖片中地點的海拔在1000-1300米呢?

o3表達,支持自己判斷結果的要素有植被、天空等。

回答是這樣的:“綜合起來,’像臺球桌一樣平坦,只有短草’的描述讓我想到了南高平原。在那個高原上,新墨西哥州東部和鄰近的德克薩斯州西部占據了最空曠、沒有圍欄的地區的中心位置——因此,定點自然而然地落在了那里。”

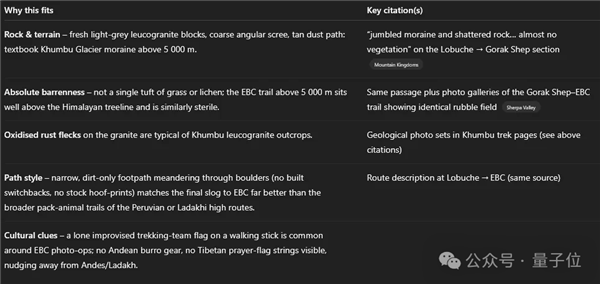

圖片2:雜亂無章的巖石和一面旗幟

講真,博主有被第一道測試驚到。

但他還是懷疑是Google街景太好猜了……

所以他放棄從Google街景截取圖片,轉而向自己的照片庫中,那些無法從網絡獲取的圖片下手了。

Be like:

這圖是博主小時候拍的。

熱愛爬山的他在尼泊爾Gorak Shep以北幾英里的Kala Pattar上插上象征自己“壯舉”的小旗子——那是他到過的最高海拔,足足18000英尺——然后拍下紀念性的一刻。

拍完照片后,博主就把旗幟拔掉了。

之所以選擇這張圖,不僅是因為現在的Google街景無法獲得這個場景,還有它不具備植被、天空這些o3在上一題中提到的判斷要素,以及它從沒告訴過ChatGPT他去過尼泊爾。

但o3再一次秀了一把,它給出答案:

尼泊爾,就在Gorak Shep的東北部,±8公里。

o3給出了解釋,主要依靠對巖石、地形的判斷。

圖片3:我朋友的女朋友的大學宿舍

不死心的博主繼續測試,第三張圖考驗的是o3對室內場景的定位能力。

作為考題的這張照片拍的是個宿舍,位于加利福尼亞州中北部羅內特公園的索諾瑪州立大學,是博主的朋友的女朋友的大學宿舍(笑死,人類為難起AI來真的是不擇手段)。

照片拍攝于2005年。

這回的結果讓博主長舒一口氣,o3答對了一部分,但沒完全答對。

o3說,這是美國一所大型公立大學校園的宿舍——比如俄亥俄州哥倫布市俄亥俄州立大學莫里爾塔(被選為原型示例而不是精確聲明),[…]約 2000-2007 年。

Fine,看來o3無法弄清楚室內場景的確切位置。

但它咋就知道是千禧年初拍攝的呢???

o3把它用來輔助判斷的關鍵兩點娓娓道來:

筆記本電腦和雜物指向~2000-2007年代的美國校園生活。

2000 年代初手機/網絡攝像頭→圖像質量顆粒感、低分辨率、色噪。

圖片4:放大的草坪特寫

在測試出o3在猜室內場景地點能力不強后,博主又轉戰戶外。

博主丟給o3的照片,是他以前在密歇根州韋斯特蘭居住時,所租賃房屋的門前草坪,局部放大版那種。

o3這次失誤了,它猜圖中的景色是美國太平洋西北部郊區/公園草坪。

第二個備選地址是英格蘭,第三個則是威斯康星。

好吧,看來只看局部草坪地圖,對o3來說真的有點難了。

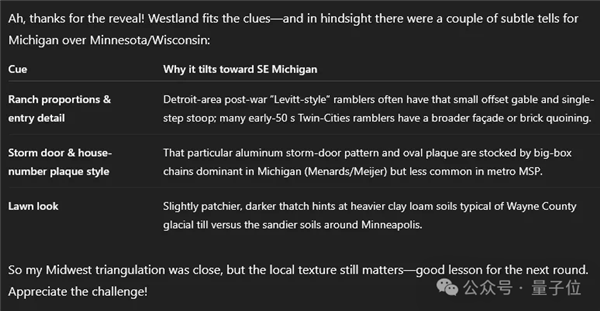

圖片5:博主家的老房子

在多次測試后,博主決定最后考考o3,以此了解一張包含更多信息的圖片是否可以讓o3獲得確切的位置,包括街道和精準地址。

這次喂過去的照片還帶剛才那張草坪,但多了一個建筑,那是博主以前在密歇根州韋斯特蘭的老房子。

出乎意料的是,o3這次回答的表現實在不佳:

W 66th St area,Richfield,Minnesota,USA。置信度:~40 % 在 15 公里內;~70 % 在雙城都會區內;其余部分在威斯康星州 (20%) 和密歇根州/安大略省 (~10%) 之間分配。

博主有點無語,信息更多了,但o3的表現居然沒有更好?猜出的結果,還不如前面幾張人類眼中信息要素更少的圖片的結果呢。

雖然他搜了下明尼蘇達州里奇菲爾德的西66街,不可思議的是,那兒確實和自己家老房子挺像。但博主還是立刻指出了o3的錯誤。

o3倒也沒急,反而給人一種事后諸葛亮的意思,“確實有一些微妙的信息證明這張圖更有可能拍攝于密歇根州比呢~”

“也許o3處于人類看圖猜地點的頂尖水平”

博文發出后,仍然有人覺得o3不能看圖猜地點能力強,只是撞大運了而已。

直到他用上了前面那段特定的提示詞:

但有人立刻站出來提出,正是因為這段prompt(它就像一段代碼一樣),o3才能猜中很多地點。

人類忽略了自己在過程中的重要性,而把猜對地點的所有功勞都歸于AI。

此外,博主還在博客中告訴了我們一個信息:GeoGuessr大師Sam Patterson和o3進行了正面交鋒,但人類輸了。

后來Sam讓其他人也和o3對著同一套圖片比拼,有少部分人以微弱優勢贏了o3。

“所以雖然沒有大勝人類,但o3也許處于人類看圖猜地點水平的第一梯隊。”

盡管如此,AI還是以我們想象不到的速度和方向不停進化著。

AI似乎正在使用人類可理解的線索——植被、天空顏色、水色、巖石類型;甚至會用一些圖像縮放工具來輔助猜測過程。

沒錯,我們之前就追蹤過一則新聞,o3會利用圖像縮放、裁剪,來輔助自己判斷圖片中的地理位置。

o3不是唯一一個能根據照片猜測地理位置的AI模型,但它的獨特之處就在于工具使用被集成到推理階段。

One More Thing

顯然,目前人們挖掘o3看圖猜地點高水平背后的秘密,有兩個要素不容忽視。

一個是借助工具,另一個是prompt加持。

那咱們就在最后分享一個關于??的prompt特別玩法,最近火遍互聯網。

具體是這樣的:

我的X用戶名是 [在這填寫你的推特用戶名]。看看我的帖子和我的受眾能產生什么共鳴,并確定我可以發展什么業務。在這個業務領域里,我會因為我的受眾而擁有壓倒性優勢。

搞笑的是,雖然o3對X的訪問受到限制,但大家覺得o3的表現居然比Grok更好。

感興趣的小伙伴們可以嘗試一下,也許對X以外的其它社交平臺也適用也說不定~

參考鏈接:

[1]https://x.com/sama/status/1918741036702044645

[2]https://x.com/KelseyTuoc/status/1917340813715202540

[3]https://www.astralcodexten.com/p/testing-ais-geoguessr-genius

[4]https://www.reddit.com/r/artificial/comments/1kep589/o3s_superhuman_geoguessing_skills_offer_a_first/

[5]https://x.com/mattshumer_/status/1918765500386902105

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播更多信息之目的,如作者信息標記有誤,請第一時間聯系我們修改或刪除,多謝。